요즘 NLP 관련된 논문들을 쭉 읽어오고 있었는데, 어느덧 RoBERTa 논문을 보게 될 차례가 왔다.

보통 논문을 볼 때 한번 쭉 읽고 다시 처음으로 돌아가서 하나씩 뜯어보는 방법으로 봐왔는데, 이때 이해가 잘 가지 않는다면 이런저런 자료들을 찾아가며 공부하곤 한다.

어김없이 RoBERTa 논문에서도 살짝 막히는 부분이 있었고, 이를 해결하기 위해 여러 자료들을 찾던 중 한빛미디어에서 출간한 구글 버트의 정석이라는 책을 참고하게 되었다.

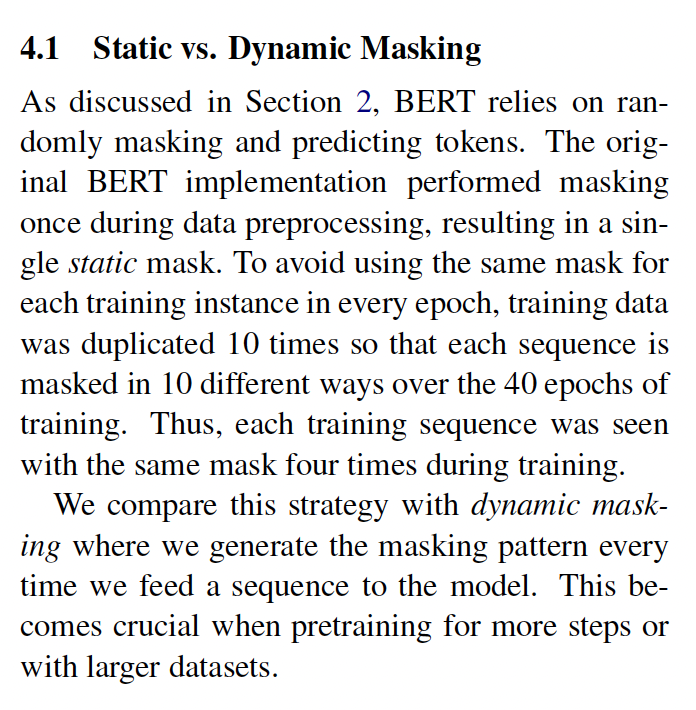

그런데, 교재에서 RoBERTa를 설명할 때 dynamic masking 부분이 더욱 이해가 가질 않았다. 교재에 의하면, dynamic masking(동적 마스킹)은 하나의 문장을 10개 복사한 뒤, 10개의 문장에 각기 다른 masking pattern을 적용하여 모델의 훈련을 진행한다고 명시되어있으며, 이외의 별다른 내용이 명시되어있지 않았는데, 논문 원본에서는 "every time we feed a sequence to the model")마다 masking pattern을 생성하는 "dynamic masking"이라고 표현을 했기 때문이다.

교재와 원본간의 괴리를 줄이고자 여러 가지 자료들을 찾아보게 되었고, ETRI 언어지능 연구실에서 발행한 딥러닝 사전학습 모델 동향이라는 자료를 찾게 되었고, 해당 자료에서도 내가 이해한 방식으로 설명이 되어있었다.

(자세한 내용은 아래의 RoBERTa 논문 리뷰에 담겨있다.)

[논문 리뷰] RoBERTa: A Robustly Optimized BERT Pretraining Approach - RoBERTa

이번에는 BERT를 발전시킨 RoBERTa를 제안한 논문인 RoBERTa: A Robustly Optimized BERT Pretraining Approach에 대해 리뷰해보려 한다. 원문 링크는 다음과 같다. RoBERTa: A Robustly Optimized BERT Pretraining Approach Language m

gbdai.tistory.com

그래서, 출판사에 문의 메일을 넣어보았다. 솔직히 보내면서도 이게 맞나 싶었고, 내가 이해를 잘 못한 게 아닌가?라는 의구심이 계속 들었지만, 아무리 봐도 내가 이해한 게 맞는 거 같기도 하였고, 공식 홈페이지의 오탈자 게시판에도 딱히 별다른 내용이 없기에 한번 해보자!라는 마음으로 정성 들여 메일을 작성하게 되었다.

이렇게 보낸 뒤, 설마 답장이 올까...?라는 마음으로 일상을 살아가던 와중, 답장이 왔다

내가 주장했던 내용이 맞았다는 내용이었다. 맨 처음 메일을 확인했을때는 어안이 벙벙했다. 솔직히 답장받을지도 몰랐고, 더욱이 역자님으로부터 바로 피드백을 받을지도 몰랐다.

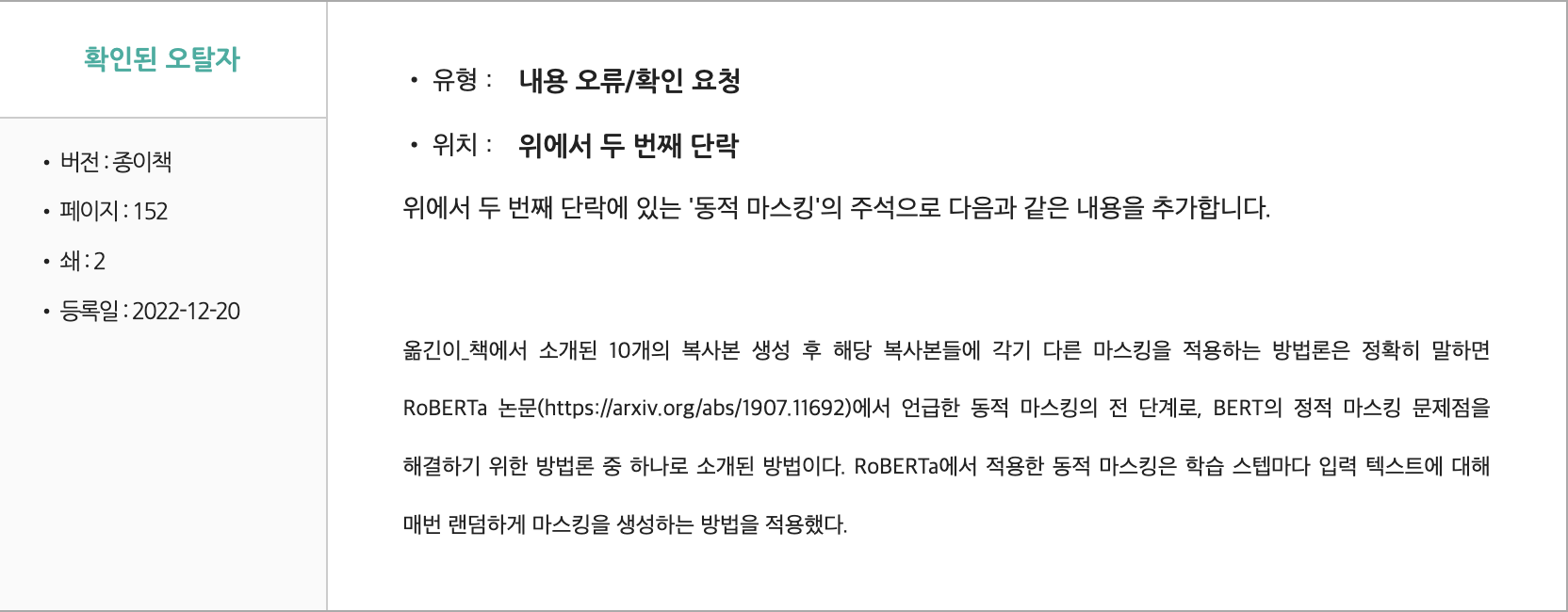

공식 홈페이지에도 들어가봤는데, 다음과 같이 정정된 내용이 명시되어 있었다.

출간된 책의 내용에 대해 출판사에 정정 요청을 한 것은 처음인데, 개인적으로 뿌듯하기도 하였고, 매우 의미 있는 활동이었다. 그리고 평소 한빛미디어에서 출판한 교재들을 엄청 많이 접해왔는데, 이렇게 빠른 피드백을 주셔서 매우 놀라기도 하였고, 정말 열심히 일하는 출판사라는 생각이 들게 되었다. 앞으로 한빛미디어 교재들에 대해 더 큰 애착을 가지고 구입할 것 같다.

'기타' 카테고리의 다른 글

| Github README 꾸미기 (0) | 2022.08.25 |

|---|---|

| [궁금증] 키오스크에는 왜 윈도우가 들어가있을까? (1) | 2022.07.23 |

댓글