Orthogonality

Orthogonal(직교)

orthogonality에 대해 간단하게 말하자면, 두 벡터 u와 v가 Rn space에 있을 때, 두 벡터의 Inner product가 0이면 orthogonal 하다고 한다.

예시와 함께 살펴보자.

예시 그림은 R3 space이며, 여기에 w라는 원점을 지나는 R3의 subspace가 W가 있고, 원점을 지나며 subspace plane W와 perpendicular, 즉 직교하는 선인 L이 존재한다.

이때, subspace W에 존재하는 임의의 벡터 w와 line L에 존재하는 임의의 벡터 z를 잡아보자.

이 두 벡터 w와 z에 대해 inner product를 취하면 0이 나오며, 서로 orthogonal 한 것을 알 수 있다.

그런데, 만약 subspace W에 있는 모든 벡터와 vector z가 Orthogonal 하면 우리는 이것을 뭐라고 불러야 할까?

이런 경우에는 벡터 z가 subspace W에 orthogonal 하다고 말한다.

즉, 벡터끼리 orthogonal 하다고 하는 것을 넘어, vector와 subspace 사이에도 orthogonal 하다고 할 수 있다.

여기서 멈추지 않고, vector z와 같이 subspace W에 orthogonal 한 모든 벡터를 가져와버리면 어떻게 표현할까?

아까 언급했듯이, 벡터 z는 line L에 있는 임의의 벡터이다.

그런데, 아까 line L은 W와 perpendicular, 즉 직교한다고 했다.

이 경우, W에 orthogonal 한 모든 벡터의 집합은 line L이 되는데, 이러한 경우에는 W의 orthogonal complement이라고 하며, W에 기호 ⊥를 달아 W⊥와 같이 표현한다.(W perpendicular이라고 읽는다)

이 예제에서는 line L은 W의 perpendicular이다라고 하며 혹은 그 반대인 subspace W은 line L의 perpendicular이다.

Orthogonal set

orthogonal set이란, Rn space에 다음과 같은 vector들의 집합이 있을 때, 각각의 set끼리 orthogonal 하면 orthogonal set이다.

즉, set 안의 임의의 벡터끼리 inner product를 했을 때 모두 0이 나오는 벡터들의 집합을 의미한다.

다음의 예제는 해당 내용을 표현한 예제이다.

위의 예시의 u1,u2,u3를 보면, 서로 각각 inner product를 취해주면 0이 나오는 것을 알 수 있다.

즉, set of vector는 orthogonal set이다.

그런데, 만약 어떤 벡터의 집합이 주어지고, 이게 orthogonal set이며 모두 nonzero vector라면,

벡터의 집합 S는 linearly independent 하며, linearly independent 하기 때문에 S를 span 하는 basis, 즉 기저 벡터가 된다.

orthogonal set이며 모두 nonzero vector일 때 linearly independent 하다는 것의 증명을 해보자.

다음과 같이 u1부터 up까지의 linear combination이 적용된 linear equation이 주어졌을 때, 해당 equation을 만족하는 c1부터 cp의 값이 전부 0인 경우만 존재한다면, linearly independent이다.

이를 알아보기 위해, 먼저 양변에 u1을 곱해준다.

orthogonal의 성질에 의해 c1u1을 제외하고 전부 0이 되기 때문에, c1u1⋅u1 부분만 남게 되고, 이때, 정의에 의해 u1이 nonzero이기 때문에 c1이 0이어야만 해당 방정식이 성립한다.

이 과정을 1부터 p까지 전부 적용시키면 c1부터 cp의 값이 전부 0이 되고, 이는 곧 linear independent를 의미한다.

Orthonormal set

orthonormal set은 unit vector로 구성된 orthogonal set이다.

다음과 같은 예시가 orthonormal set의 한 예시이다.

Orthogonal basis

orthogonal basis는, orthogonal set인데 어떤 subspace의 basis면 orthogonal basis가 된다.

이러한 orthogonal basis는 일반적인 basis가 가지지 못하는 장점이 있다.

subspace안의 임의의 벡터 y가 있다고 가정하면, basis이기 때문에 다음과 같이 linear combination으로 표현이 가능하다.

이때 orthogonal basis을 통해 해당 linear combination의 coefficient가 아래와 같이 주어진다.

orthogonal basis가 아닌 경우에는 첨가 행렬을 통해 row reduction을 통해 coefficient를 구했어야 했는데,

orthogonal basis를 이용하면 간단히 coeffcient를 구할 수 있게 되는 것이다.

원리에 대해 자세히 살펴보자면, orthogonal set에서 식을 전개했던 것과 마찬가지로 orthogonality를 이용해 양변에 u1를 곱해주면 같은 vector의 inner product만 남고 다 0이 되어서 아래와 같은 식이 나오고, 이를 c1에 대해 정리하면 위와 같은 coefficient 식이 나오게 되는 것이다.

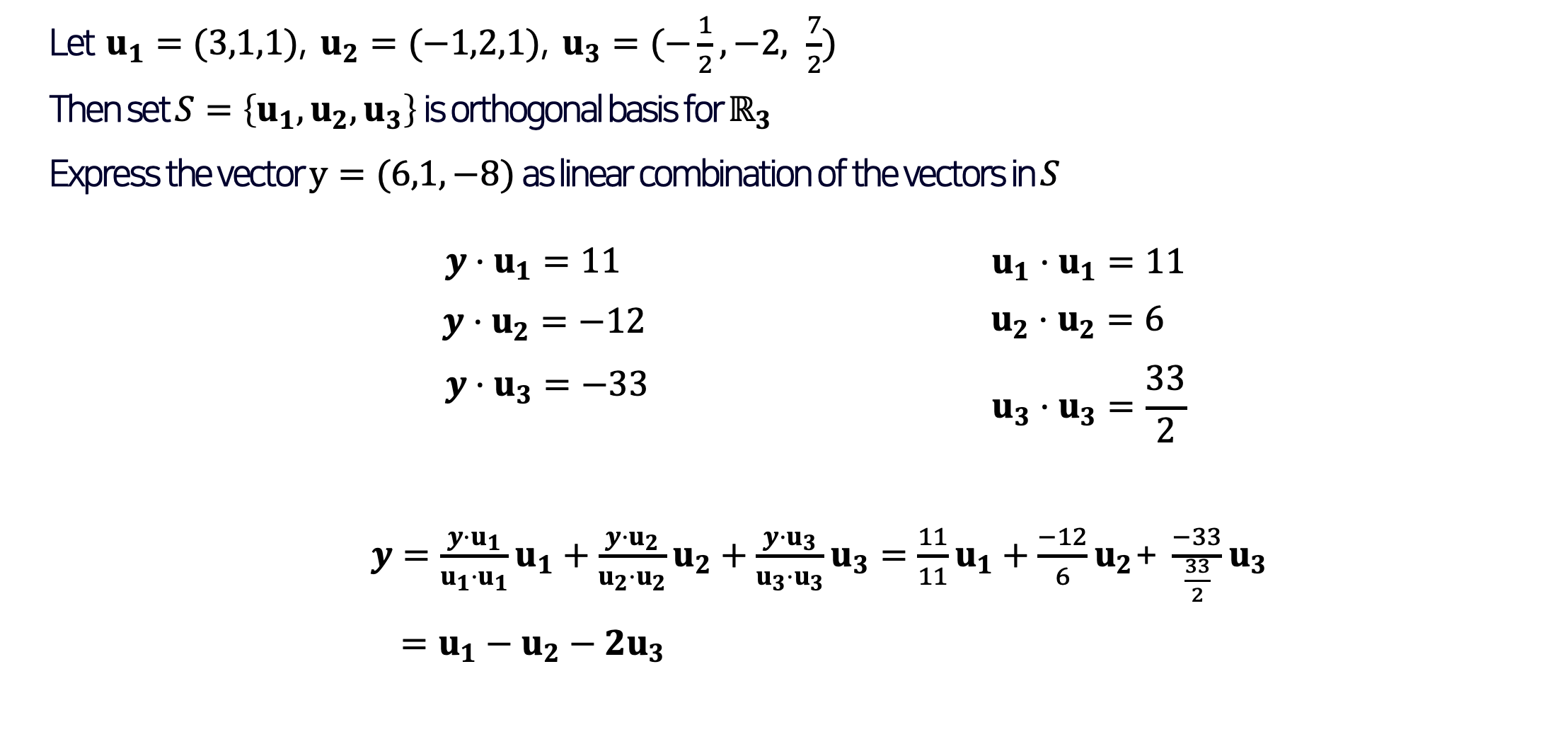

이 과정을 예제를 통해 한번 더 살펴보자. 다음은 orthogonal basis의 예제이다.

다음과 같은 u1,u2,u3 벡터들이 주어지고 해당 set of vector는 R3 space의 orthogonal basis라고 한다.

이때 벡터 (6,1,−8)을 linear combination으로 표현해야 하는데, 위에서 봤던 coefficient공식을 통해 쉽게 표현할 수 있다.

Orthogonal Projection

먼저, 이해를 돕기 위한 예시를 보자

우선, B라는 Rn space의 orthogonal basis가 주어질 때 Rn space의 임의의 벡터 y를 y=c1u1+⋯+cnun와 같이 linear combination으로 표현한다.

예제에서처럼 R2space기준으로, y벡터가 있다고 가정해보자.

그렇다면 u1벡터 방향에 해당되는 cordinate vector의 entry는 c1이다. 또한 u2벡터 방향에 해당되는 cordinate vector의 entry는 c2이다.

즉, y를 u1방향에 projection 했을 때 값은 c1u1이 해당 orthogonal projection의 값이 됩니다.

이때 projection을 Orthogonal projection of y onto u1(or onto L)이라고 표현한다.

수식으로는 다음과 같이 표현합니다.

또한 y를 y=ˆy+z와 같이 표현할 수 있는데,

이때 이 z벡터의 경우에는 component of y orthogonal to u1(or onto L)라고 한다.

이 과정의 일반화는 다음과 같은 공식으로 표현될 수 있다.

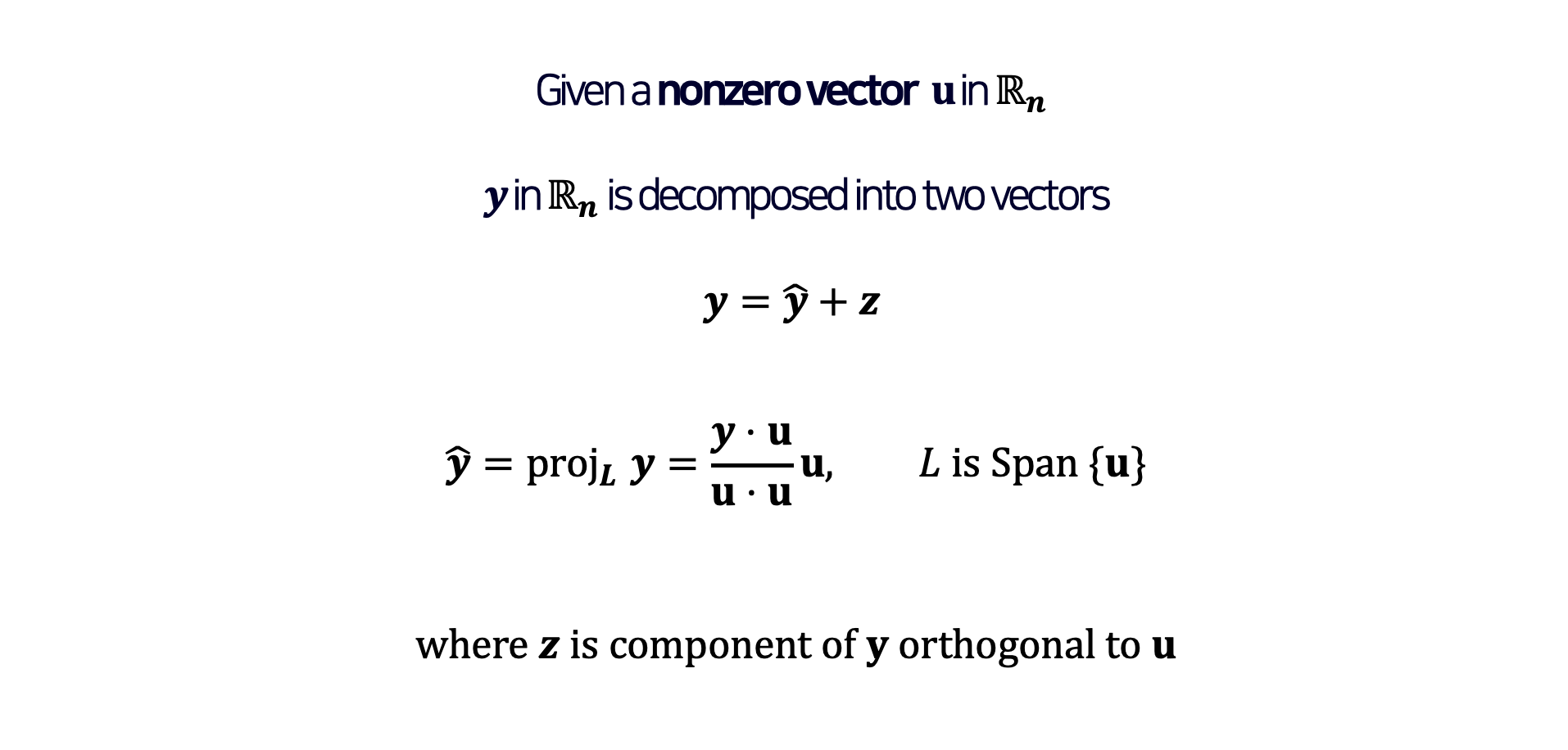

하나씩 차근차근 따라가 보자. 우선 Rn space에 nonzero 벡터 u가 주어졌을 때, Rn space에 주어진 벡터 y는 ˆy와z, 두 개의 벡터로 decompose 될 수 있다고 한다.

이때 ˆy은 y를 u를 span 한 line에 projection 한 값이며, z는 u에 orthogonal 한 y의 component이라고 표현한다.

orthogonal projection의 예제를 함께 살펴보자

find the orthogonal projection of y onto u를 하라고 하는데, 즉 ˆy를 찾는 것이다. ˆy을 찾은 이후에는 y를 decompose 하여 두 벡터로 표현하는 문제이다.

지금까지는 vector 간의 Orthogonal projection에 대한 내용이었는데, 지금부터는 subspace의 orthogonal projection에 대해 다뤄보도록 하겠다.

Rn space에 subspace W가 주어졌다고 가정해보고, 임의의 vector y를 잡았을 때. y를 subspace 자체에 Orthogonal projection 시키면 subspace안에 있는 vector ˆy으로 projection 된다.

이후, y는 ˆy과 Orthogonal 한 관계에 있는 또 다른 vector z 형태로 decompose 된다.

또한 ˆy은 ˆy=c1u1+⋯+cpup와 같은 linear combination으로 표현이 되는데, 이걸 이용해서 y=ˆy+z 식을 표현하고, 양변에 u1을 곱해준다.

양변에 u1을 곱해준 식을 분배 법칙으로 풀게 되면 ˆy⋅u1+z⋅u1 이 나오게 되는데, z는 W와 perpendicular 하기 때문에 z⋅u1는 0이 된다.

이후 orthogonal 한 성질로 인해 같은 벡터의 inner product 이외에는 다 0이 되고, 다음과 같이 c1u1⋅u1이 남게 된다.

이를 통해 c1을 위 예시의 마지막 수식과 같이 구할 수 있게 되고, 특정 weight cj도 구할 수 있게 된다.

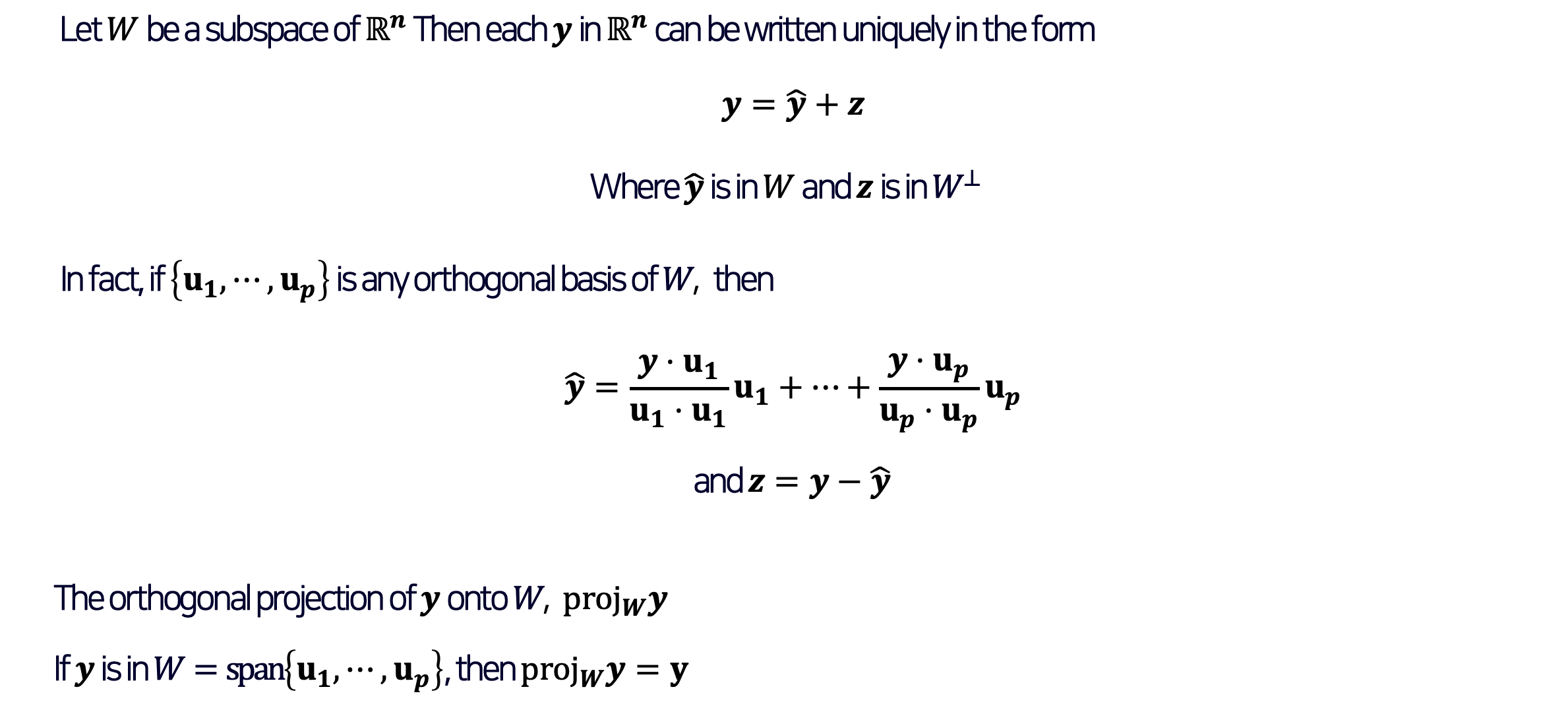

이것을 이론화하면 다음과 같다.

Rn subspace의 subspace W가 있을 때, 임의의 Rn space에 있는 y는 다음과 같이 표현되는데, 이때 ˆy은 앞에서 본 것처럼 subspace에 있는 친구이고, z는 subspace와 perpendicular 한 vector이며 ˆy은 위의 예제처럼 표현 가능하다. 또한, orthogonal component z는 위의 과정에서 ˆy이 구해지면 y−ˆy의 과정으로 구할 수 있다.

이렇게 subspace W에 y를 orthogonal projection 하면 projLy와 같이 표기하며,

만약 y가 subspace W 안에 있다면 y를 W에 projection 한 것은 y와 같아진다. (해당 subspace 안에 있기 때문에 projection을 해도 그대로인 것이다.)

'MATH' 카테고리의 다른 글

| [선형대수학] Inner product(내적)와 Length, Distance (0) | 2022.12.17 |

|---|---|

| [선형대수학] Gauss-Jordan elimination(가우스-요르단 소거법)과 Solution of linear system (1) | 2022.12.06 |

| [선형대수학] Linear Equation(일차방정식) (0) | 2022.09.17 |

댓글